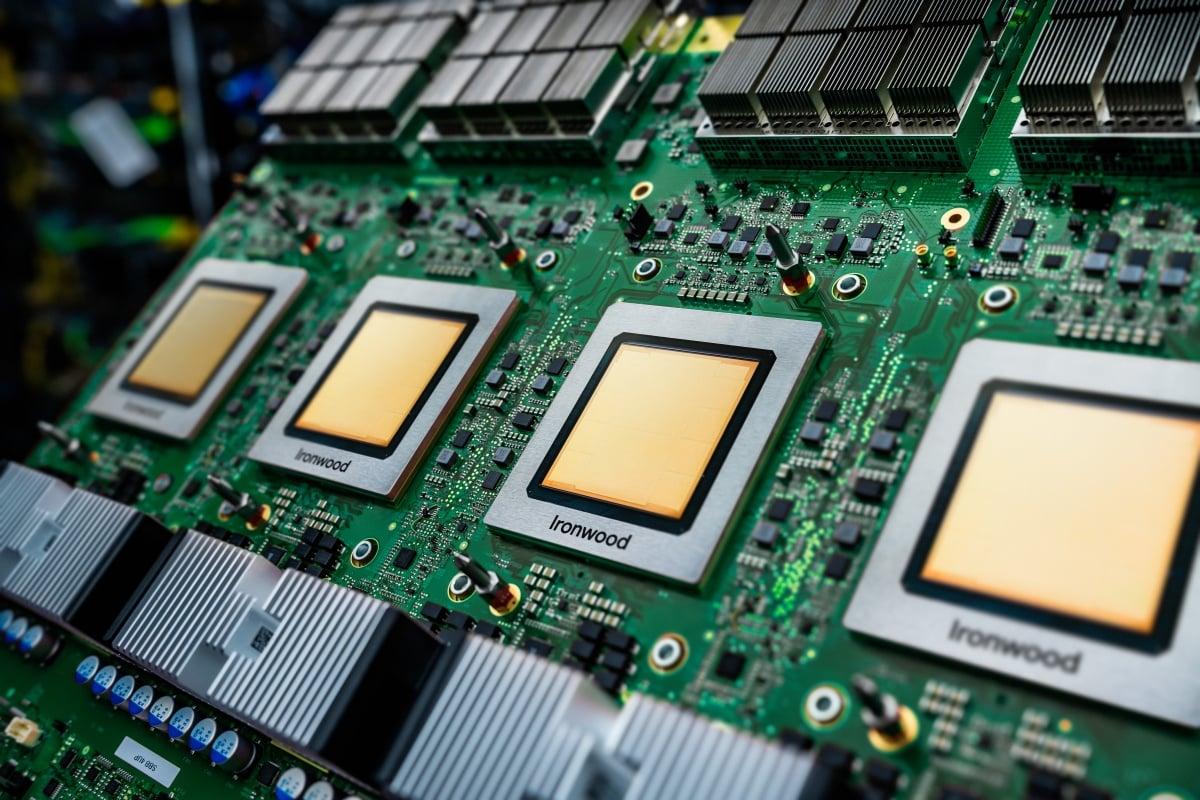

La aceleración de la inteligencia artificial está moviendo el foco hacia la inferencia a gran escala, y Google Cloud ha respondido con Ironwood, su TPU de séptima generación. Este chip llega con una propuesta que combina más rendimiento, mejor eficiencia y costes ajustados para desplegar modelos avanzados en producción.

En un contexto en el que empresas de España y Europa buscan operar modelos complejos con baja latencia, Ironwood desembarca como una opción diseñada para servir peticiones masivas y, a la vez, sostener entrenamientos exigentes cuando haga falta. Además, Google confirma que la disponibilidad general se activará en las próximas semanas.

La era de la inferencia y el papel de Ironwood

Ironwood se presenta como la TPU más avanzada de Google hasta la fecha, con un salto de rendimiento de hasta 10 veces frente a v5p y más de 4 veces por chip respecto a la serie v6e para tareas de entrenamiento e inferencia. El objetivo es dar respuesta a cargas que crecen sin parar y a modelos de última generación que ya trabajan con millones de usuarios.

La compañía subraya que Ironwood está especialmente optimizada para la fase de uso en producción, donde la clave es responder millones de veces al día con latencias bajas y costes predecibles. Aun así, el diseño permite ejecutar también entrenamiento y aprendizaje por refuerzo cuando se requiere escalar capacidades.

Google prevé una adopción amplia por parte de su ecosistema: Anthropic, creadora de Claude, planea utilizar hasta un millón de TPU para impulsar la expansión de sus servicios. Este tipo de despliegues masivos en infraestructura de IA ilustra la competencia creciente en infraestructura de IA y la necesidad de recursos de cómputo dedicados.

Para clientes europeos y españoles, el atractivo reside en combinar picos de potencia con eficiencia operativa y un catálogo cloud integrado que facilita la puesta en producción de modelos sin rehacer pipelines.

Arquitectura: ICI a 9,6 Tb/s, 9.216 chips y HBM compartida

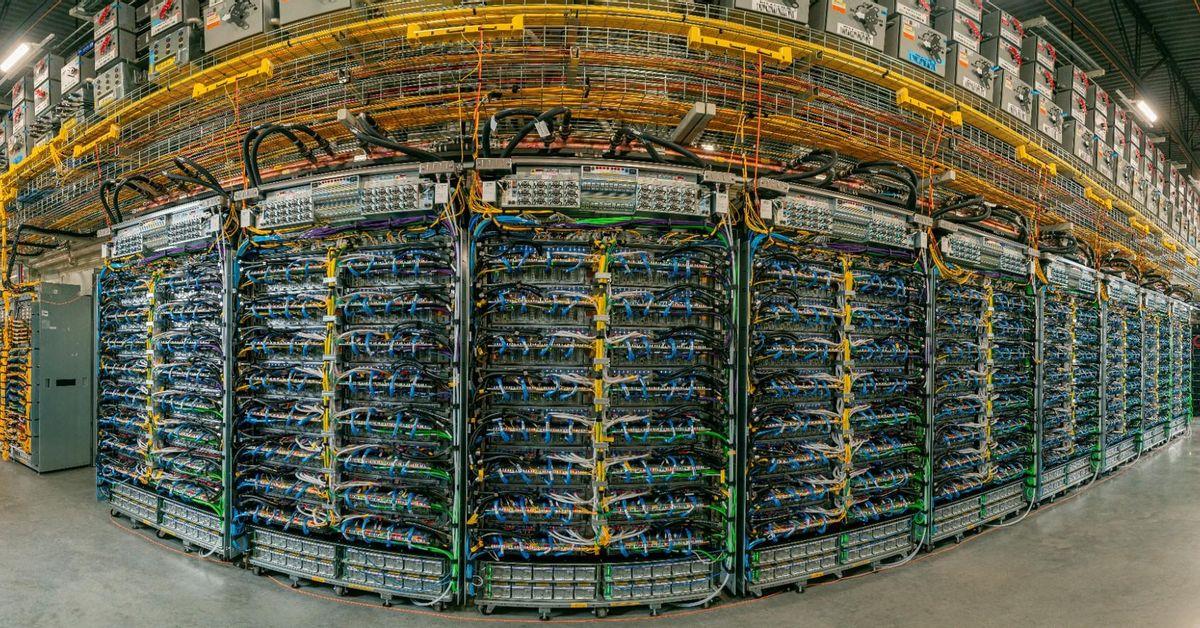

El corazón técnico de Ironwood está en su malla de interconexión: la Inter-Chip Interconnect (ICI) enlaza hasta 9.216 chips en un único pod con velocidades de 9,6 Tb/s. Esta topología minimiza los cuellos de botella habituales y permite que los modelos más grandes se sirvan con fluidez.

Otro elemento clave es la memoria compartida: el sistema puede exponer 1,77 petabytes de HBM para mantener los modelos completamente cargados y acelerar la inferencia, un punto crítico cuando la demanda se dispara y la experiencia depende de la velocidad de respuesta.

En fiabilidad, la plataforma introduce conmutación óptica OCS que redirige dinámicamente el tráfico ante incidencias, con niveles de disponibilidad citados por la compañía cercanos al 99,999%. Este enfoque fortalece la continuidad de servicios y reduce el impacto de fallos en operaciones críticas.

Ironwood escala más allá del pod gracias a la infraestructura de red y centros de datos de Google, lo que permite agrupar centenares de miles de TPU cuando los proyectos exigen un salto de capacidad. La refrigeración líquida y la cooptimización de plataforma ayudan a mejorar la eficiencia energética a gran escala.

AI Hypercomputer y el tándem con Axion

Ironwood se integra en el marco AI Hypercomputer, que unifica cómputo, red, almacenamiento y software bajo un diseño conjunto. Según cifras citadas por Google, clientes de esta arquitectura han logrado un ROI del 353% a tres años y reducciones de costes de TI de hasta el 28%, fruto de un stack optimizado de arriba abajo.

En software, Google ha reforzado la ejecución gestionada con Cluster Director en GKE, mejoras en MaxText para entrenamiento LLM y soporte de vLLM que facilita alternar GPU y TPU con ajustes mínimos. Para la inferencia, GKE Inference Gateway reduce el arranque frío hasta un 96% y puede recortar costes de servicio en torno al 30%.

Como complemento, llegan nuevas máquinas virtuales basadas en Axion (Arm) para cargas generales: la instancia N4A en vista previa ofrece hasta 64 vCPU y 512 GB de memoria, con ganancias de precio-rendimiento frente a opciones x86 comparables. Además, C4A metal introduce bare-metal en Arm para necesidades especializadas.

Las primeras pruebas aportan señales claras: Vimeo detectó cerca de un 30% más de rendimiento en transcodificación con N4A, mientras ZoomInfo midió alrededor de un 60% de mejora en precio-rendimiento en procesos de datos clave. Esta capa de CPU eficiente descarga tareas de soporte y alimenta los pipelines sobre los que Ironwood acelera la IA.

Para el tejido empresarial en España y la UE, la combinación de TPU y CPU personalizadas apunta a una computación más híbrida, escalable y controlable, reduciendo latencias, costes por inferencia y complejidad operativa a medida que los casos de uso pasan de pilotos a producción.

El lanzamiento de Ironwood, junto con el refuerzo de Axion y el ecosistema AI Hypercomputer, configura un escenario en el que la inferencia se convierte en la métrica clave de competitividad: más rendimiento por euro, disponibilidad robusta y un camino de adopción que favorece a quienes necesitan desplegar modelos punteros con rapidez y sin sobresaltos.

[relacionado url=»https://foropc.com/samsung-y-nvidia-levantaran-una-megafabrica-de-ia-con-50-000-gpus/»]