La idea de montar un asistente personal de IA sobre una Raspberry Pi lleva tiempo rondando la cabeza de muchos makers, y no es para menos: con los modelos lingüísticos modernos y una placa que consume poco, puedes tener en casa un sistema que te escuche, hable y automatice tareas sin depender de terceros. En las últimas iniciativas públicas se mezclan enfoques en la nube y totalmente locales, y ambas vías han demostrado ser viables, divertidas y sorprendentemente efectivas.

En este recorrido reunimos varios proyectos destacados y guías técnicas: desde una app web sencilla que integra un modelo estilo GPT para consultas de Raspberry Pi, hasta dos asistentes de voz que funcionan en la Pi con reconocimiento local, y uno de ellos con todo el pipeline en el propio dispositivo. Verás qué hardware usan, cómo se conectan a modelos grandes, qué librerías emplean y qué medidas de seguridad conviene aplicar, todo ello con detalles prácticos para dejarlo funcionando en tu entorno.

Qué puede hacer hoy un asistente de IA en Raspberry Pi

Los asistentes que combinan una Raspberry Pi con modelos de lenguaje han pasado de ser prototipos curiosos a soluciones útiles. Un buen ejemplo es una herramienta integrada en un panel de control para la Pi que permite preguntar dudas relacionadas con la placa y su ecosistema. La aplicación es sencilla, con un cuadro de texto y varias utilidades para gestionar las conversaciones (renombrar, denunciar, eliminar o crear hilos), y aún así demuestra que con componentes mínimos se obtiene una experiencia fluida y cercana.

Este asistente está pensado para dar soporte sobre Raspberry Pi y tecnología afín, lo que ayuda a acotar el dominio y a obtener respuestas más precisas. Aun así, también puede contestar cuestiones generales, aunque recuerda al usuario que su foco principal es la Pi y la electrónica que la rodea. La clave está en su integración con un proveedor de modelos, lo que permite que las réplicas lleguen por streaming, a medida que se generan, dando una sensación de inmediatez.

Para replicar una experiencia así en tu entorno, la ruta más directa pasa por clonar el repositorio del proyecto y preparar el entorno de ejecución. En la práctica, lo que necesitas es tener instalado Node.js, npm y el gestor de paquetes yarn en tu máquina (funciona en una Raspberry Pi 4 o en cualquier equipo compatible con Node). Después de descargar el paquete de Node para tu arquitectura (en una Pi 4, ARMv8), instalarlo y verificar versiones, solo queda instalar dependencias del proyecto y construir la app para servirla localmente.

Hay un requisito importante que no debes pasar por alto: hace falta una clave de API de un proveedor compatible con modelos estilo GPT. En tu cuenta, generas una credencial y la colocas en la configuración del proyecto (por ejemplo, en el archivo de configuración del framework web, tal como se describe en su documentación). Una vez listo, levantas el servidor y accedes desde el navegador a la dirección local, donde verás cómo el texto del asistente aparece al ritmo de la generación, lo que resulta muy cómodo para ir leyendo sin esperar a que termine la respuesta.

La guía del proyecto recuerda que el proceso es sorprendentemente rápido: desde el clonado, pasando por la instalación y la configuración de la clave, hasta abrir la página en tu navegador. Incluso incorporan la promesa de un vídeo de demostración con el asistente en acción, que ilustra la lógica de una interfaz mínima, una API bien configurada y un flujo de conversación que prioriza la utilidad para la comunidad de Raspberry Pi.

Asistentes locales y privados: ASRAI y Max Headbox

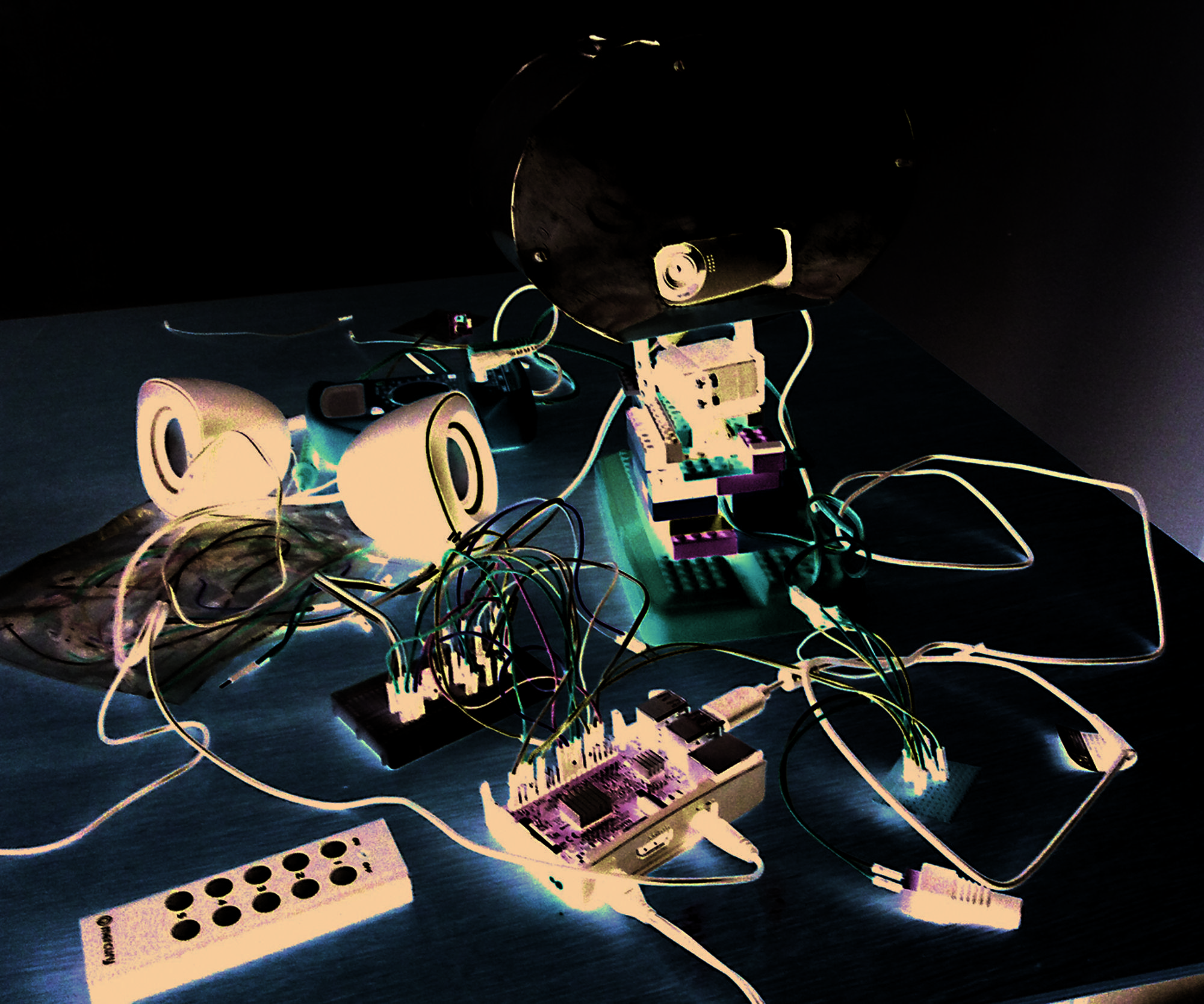

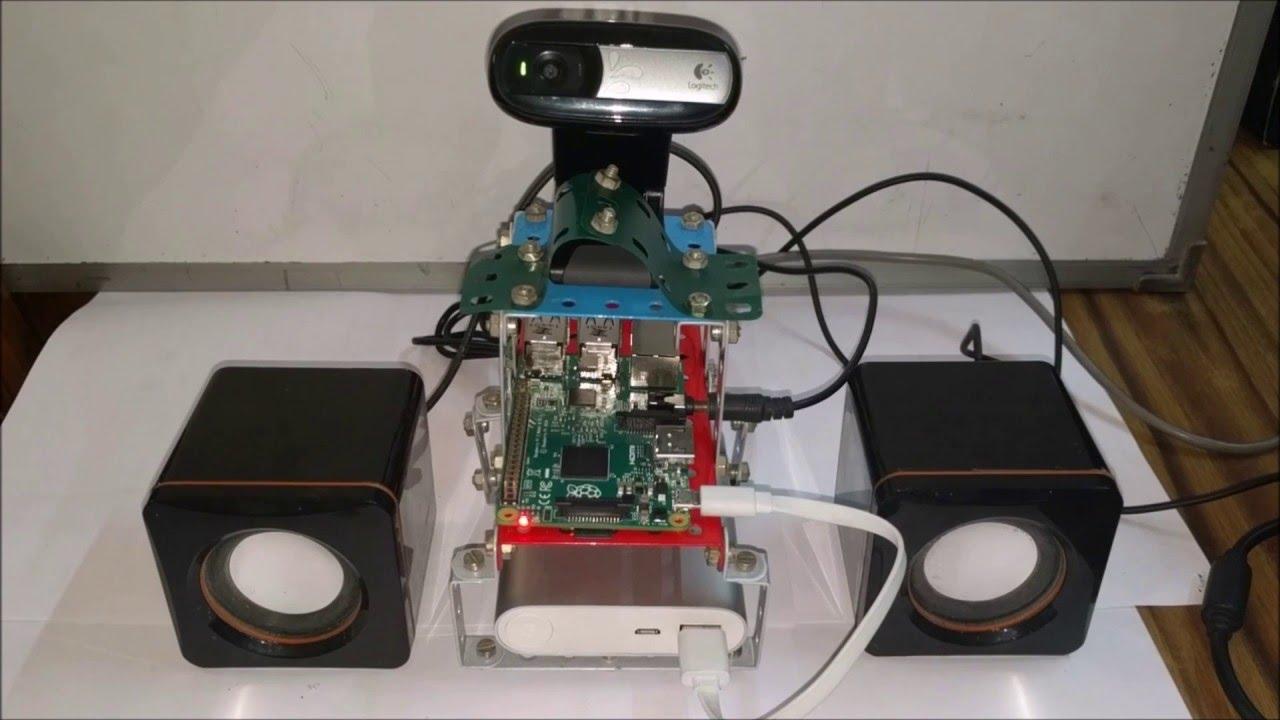

Si te interesa llevar el control de todo el pipeline a tu casa, hay proyectos de código abierto que apuestan por la privacidad y el procesamiento local. Uno de ellos, bautizado ASRAI por su autor, combina una Raspberry Pi 4 Modelo B con una cámara Sony PlayStation Eye y una pantalla GPIO de 3,5 pulgadas para construir un asistente personal hablado. Lo bonito del invento es que la PlayStation Eye incluye una matriz de cuatro micrófonos, fácilmente reutilizable en la Pi, y se puede encontrar de segunda mano por un precio ridículo, en torno a cuatro dólares.

En ASRAI, la detección y reconocimiento de voz se ejecuta de forma local en la Pi con Vosk, y el modelo de lenguaje grande vive en otra máquina del autor a la que accede vía una API compatible con OpenAI proporcionada por Ollama. Para cerrar el círculo, el acceso remoto se resuelve con Meshnet de NordVPN, lo que le permite hablar con su asistente desde cualquier parte sin exponer servicios de forma insegura. Este enfoque híbrido mantiene el audio en local y solo envía texto a un modelo en su propio equipo, equilibrando privacidad, coste y potencia.

Además del bloque técnico, su creador se tomó la molestia de darle personalidad al asistente con imágenes distintas para cuando está dormido o escuchando. Si te animas a replicarlo, puedes descargar su proyecto y reemplazar esas imágenes por las tuyas. Eso sí, ten a mano impresora 3D y soldador, porque la adaptación del microarray y el montaje de la carcasa requieren algo de maña, aunque la documentación explica los pasos con detalle suficiente para makers.

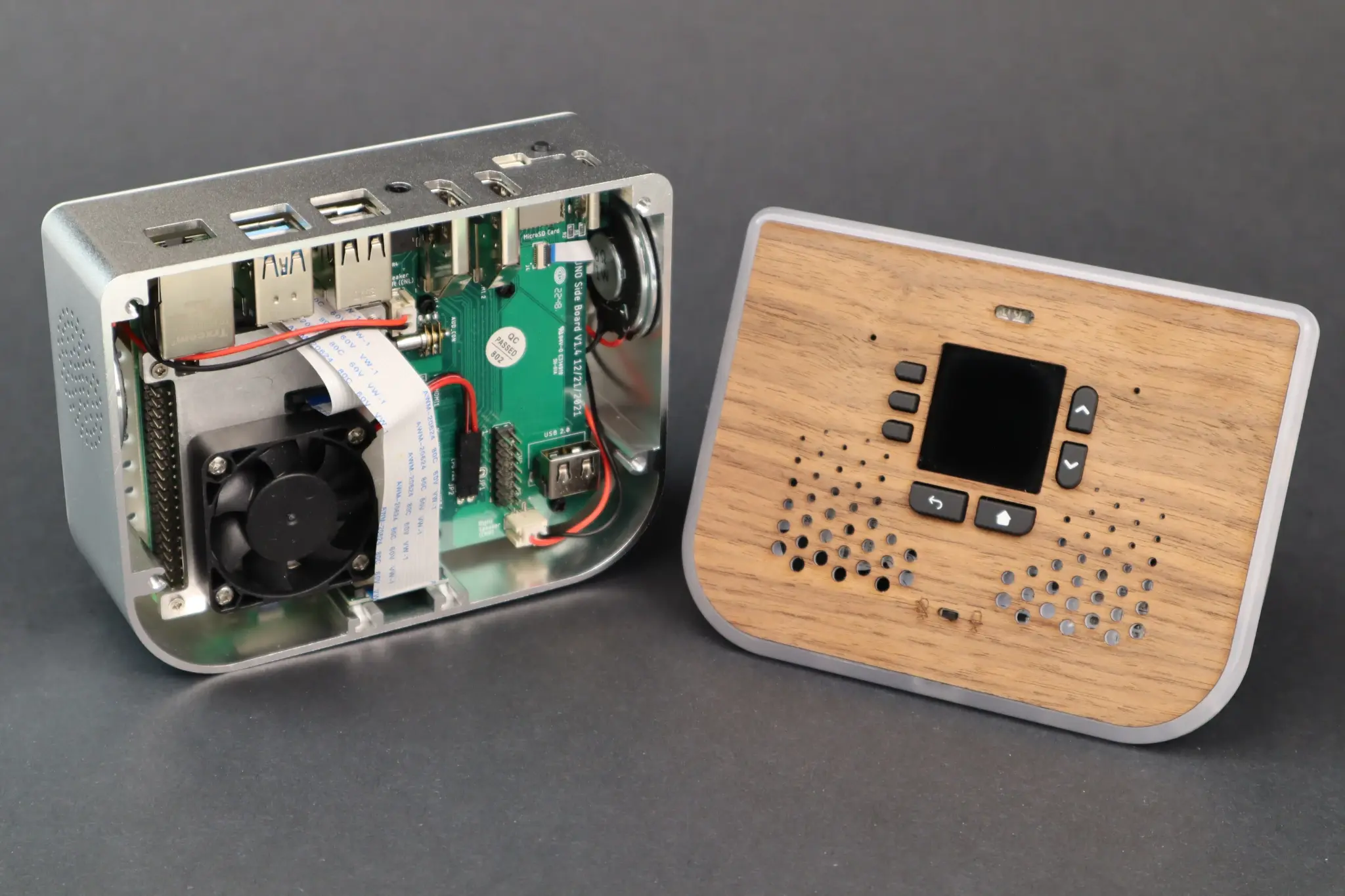

Otra aproximación igual de interesante, pero esta vez cien por cien local, es Max Headbox, un agente diminuto que corre íntegramente en una Raspberry Pi 5 con 16 GB de RAM. Aquí no hay llamadas externas: la detección de palabra de activación se resuelve con Vosk, la transcripción con Faster-Whisper y la inferencia del modelo de lenguaje se hace con modelos ligeros (Qwen3 de 1,7B y Gemma3 de 1B) adaptados a las limitaciones de la Pi. Con todo dentro del dispositivo, se consigue un asistente de voz que ofrece respuestas offline con baja latencia para tareas del hogar.

Max Headbox añade un guiño simpático con una cara animada que reacciona durante la conversación, aportando calidez a la interacción. Aunque es obvio que no compite en potencia con los gigantes en la nube, su diseño encaja muy bien con escenarios reales: consultar el tiempo, encender o apagar luces, manejar rutinas simples de domótica o responder preguntas cotidianas sin ceder datos a terceros. El autor ha publicado una entrada de blog con todo el proceso y el código en GitHub, así que tienes referencias prácticas y reproducibles para clonar el proyecto por tu cuenta.

Si te pica la curiosidad técnica, puedes revisar la entrada del autor en su blog (enlace: blog.simone.computer/an-agent-desktoy) y el repositorio (enlace: github.com/syxanash/maxheadbox). También hay artículos que se hacen eco de estos montajes y de experimentos adicionales con Raspberry Pi 5, donde se prueban diferentes IA locales para comparar su rendimiento sin necesidad de que tú hagas todas las pruebas a mano, algo muy útil si quieres decidir qué modelo pequeño encaja mejor con tu caso.

Raspberry Pi 5 como base: hardware, librerías y flujo

La Raspberry Pi 5 ha supuesto un salto en potencia que se nota al montar asistentes de voz. Con CPU más rápida y más memoria, es posible mantener varios procesos simultáneos (captura de audio, detección de palabra, transcripción, síntesis de voz y lógica del agente) sin que el sistema se arrastre. Este balance entre rendimiento y consumo hace de la Pi una plataforma ideal para construir asistentes de IA y sistemas de automatización doméstica de bajo coste.

A nivel de hardware, puedes combinar la placa con micrófonos USB o HATs con microarrays, cámaras para visión básica y pantallas pequeñas si te apetece darle cara al asistente. La conectividad Wi‑Fi y Bluetooth integrada facilita que se comunique con sensores y bombillas inteligentes o con un broker de domótica local. Con un par de pines GPIO, además, puedes añadir botones físicos o LEDs que indiquen estados como escuchando, pensando o hablando.

El flujo típico de un asistente parte de la voz: primero se detecta una palabra de activación o wake word; después se transcribe el audio a texto; a continuación entra en juego el procesamiento del lenguaje natural para entender la intención del usuario y, por último, se ejecuta la acción (consultar el tiempo, controlar un enchufe, buscar una receta) o se genera la respuesta hablada. Hay muchas combinaciones válidas, pero bibliotecas como PocketSphinx o Google Speech Recognition sirven de base para pruebas, mientras que Vosk o Whisper en sus variantes rápidas acercan la latencia a lo que esperamos en una conversación natural.

Si prefieres empezar con un enfoque más de escritorio, un caso práctico es instalar Raspberry Pi OS Lite (la edición ligera) para maximizar recursos y montar un entorno Python con librerías como SpeechRecognition para el reconocimiento de voz y pyttsx3 para la síntesis. Con unos cuantos scripts podrás manejar slots de intención, llamar a APIs o servicios locales, y crear tus propias respuestas con plantillas, de modo que el asistente suene coherente y útil en las tareas que de verdad te importan.

Y si decides integrar un LLM en la mezcla, puedes optar por varias rutas: delegar la parte lingüística a un servicio externo compatible con API tipo OpenAI (como hace el asistente web orientado a consultas sobre la Pi), o mantenerlo todo en casa ejecutando modelos livianos con Ollama u otras herramientas diseñadas para equipos modestos. El enfoque híbrido (voz local + LLM en tu PC) ofrece una gran relación entre privacidad y calidad de respuesta, mientras que el enfoque totalmente local, como Max Headbox, maximiza independencia y control sobre tus datos.

Guía práctica inspirada en proyectos reales

A partir de los proyectos descritos se puede trazar una hoja de ruta flexible. Si tu objetivo es una interfaz web de consulta con un modelo de lenguaje, clona el repositorio del proyecto que usa un framework moderno (por ejemplo, Nuxt) y prepara Node, npm y yarn. Tras instalar dependencias, configura tu clave de API en el archivo de ajustes correspondiente y lanza la aplicación. Cuando la tengas en marcha en la dirección local, fíjate en cómo las respuestas aparecen en streaming y cómo puedes gestionar tus chats con opciones de renombrado y borrado.

Para un asistente de voz tipo ASRAI, apuesta por una Pi 4B, la PlayStation Eye (por su matriz de micrófonos de cuatro cápsulas tan barata) y una pantalla pequeña. Monta Vosk para reconocimiento local y conéctate a un modelo de lenguaje que tengas en tu ordenador vía Ollama, protegiendo el acceso con Meshnet para no abrir puertos a lo loco. Personaliza la estética con imágenes para los estados de reposo y escucha, imprime la carcasa y comprueba que los micrófonos capturan bien desde la distancia. Todo el audio se procesa en la Pi, y solo viajes texto al modelo externo, mejorando la privacidad del sistema.

Si te apetece el reto máximo, inspírate en Max Headbox: Raspberry Pi 5 con 16 GB, detección con Vosk, transcripción con Faster‑Whisper y modelos ligeros como Qwen3 de 1,7B o Gemma3 de 1B para la inferencia. Optimiza la prioridad de procesos, prueba cuantizaciones adecuadas y mantén el pipeline en memoria para evitar cuellos de botella. Así lograrás un asistente 100 % local, muy útil para domótica y preguntas generales, con una cara animada que haga de interfaz. Esta vía prioriza privacidad y control absoluto, con la contrapartida de que las respuestas más complejas pueden tardar un pelín más que en la nube.

En todos los escenarios, recuerda documentarte: hay artículos y posts que profundizan en la experiencia de convertir la Raspberry Pi en un asistente, así como comparativas de IA ejecutándose en la Pi 5 que te ahorran pruebas. Algunas de estas reseñas enlazan a recursos como un documento académico que analiza implicaciones operativas y técnicas de un asistente conectado a través de Pi 5, que te vendrá bien si quieres dar un paso atrás y ver el cuadro completo: desde el ahorro energético hasta el impacto en la eficiencia diaria, pasando por el coste de propiedad cuando eliges hardware económico. Puedes consultar un PDF de referencia en: descargar PDF.

Buenas prácticas de seguridad para asistentes caseros

Cuando montas un dispositivo que escucha y habla en tu red, la seguridad ya no es opcional. Mantén el sistema operativo de la Pi y todas las librerías al día para evitar exploits conocidos. Si tu asistente expone endpoints, protégelos tras autenticación y, si es posible, en una red aislada para dispositivos IoT. El cifrado punto a punto en las comunicaciones entre la Pi y cualquier otro equipo es esencial para que tus datos no viajen en claro.

Otra recomendación útil es crear una VLAN o una red Wi‑Fi separada para los cacharros del hogar. Así, si algo se complica, limitas el alcance del problema. Es buena idea auditar los puertos abiertos y vigilar el consumo y tráfico de la Pi para detectar comportamientos extraños. El principio de mínimos privilegios aplica también aquí: evita que el usuario del servicio tenga permisos que no necesita y desactiva lo que no uses. Con estas prácticas, un asistente DIY deja de ser un punto débil en tu red y se convierte en un ciudadano ejemplar.

Conviene, además, estar al día de vulnerabilidades asociadas al IoT. Sin entrar en detalles específicos de la Pi 5, CVEs como 2021‑22945 o 2021‑22946 ilustran problemas que pueden afectar a componentes y servicios del ecosistema. Monitorea las listas de avisos, aplica parches cuando toquen y documenta tus dependencias. Si utilizas servicios remotos tipo Meshnet para conectar con un modelo alojado en tu PC, configura el acceso con claves robustas, revisa los logs y aplica rotación periódica de credenciales.

Ideas de uso, rendimiento y pequeños trucos

Una vez en marcha, los casos de uso cotidianos florecen: rutinas de luces y enchufes, recordatorios, información del tiempo, timers en la cocina, control de reproductores o consultar datos de tus sensores caseros. Si empleas un enfoque híbrido como ASRAI, notarás respuestas más ricas del LLM con un coste razonable; si sigues la senda de Max Headbox, disfrutarás de la tranquilidad de no depender de Internet. En ambos, procura ajustar la sensibilidad del wake word para evitar activaciones no deseadas.

Para mejorar la latencia, asegúrate de que la tarjeta microSD no sea el cuello de botella; una SSD por USB 3 en la Pi 5 suele marcar la diferencia. Mantén los modelos en formatos optimizados y cuida la prioridad de hilos del pipeline de audio. Si usas una matriz de micrófonos como la de la PlayStation Eye, prueba con formación de haz (beamforming) y cancelación de ruido donde el entorno sea ruidoso. Son pequeños cambios que elevan la experiencia de un asistente que, al final, responde rápido y claro.

Si vas a integrar una interfaz visual, una pantalla GPIO de 3,5 pulgadas es suficiente para mostrar ondas, estados o la cara animada del agente. Puedes reusar imágenes para indicar reposo y escucha, o animaciones sencillas sincronizadas con la voz de salida. Para la síntesis, prueba con motores locales si quieres mantener todo en la Pi, o con servicios remotos si priorizas naturalidad de voz. Ajusta el volumen y una indicación luminosa clara cuando el micrófono está capturando audio.

Otra fuente de inspiración son las pruebas comparativas de distintos modelos y configuraciones en Raspberry Pi 5 que han publicado algunos autores. Estas guías prácticas te ahorran tiempo determinando qué modelos y parámetros funcionan mejor en la Pi, qué versiones de librerías son más estables y qué compromisos debes aceptar para mantener la experiencia por debajo de cierto umbral de latencia. Tomar decisiones informadas en esta fase te da un asistente estable y agradable de usar a diario.

Y si buscas soporte o comunidad, hay repositorios y foros donde los autores comparten avances, problemas y mejoras. El hilo de Max Headbox en redes sociales técnicas ha servido para recoger feedback y nuevas ideas, mientras que páginas de proyectos como Hackster detallan montajes como ASRAI paso a paso. En artículos de medios especializados se recopilan hallazgos, se comparan metodologías y se enlazan recursos útiles, como este de xda-developers: xda-developers. Son puntos de partida fantásticos para aprender y iterar.

Aunque no todos los usuarios vayan a necesitar el máximo control, el abanico de soluciones demuestra que hay un asistente para cada escenario: desde la app web que se integra con un modelo potente para resolver dudas sobre la Pi al momento, hasta los agentes offline que priorizan la privacidad y la soberanía del dato. Con algo de paciencia para el montaje, atención a la seguridad y ganas de trastear, la Raspberry Pi vuelve a lucirse como una plataforma versátil para IA personal que cabe en la palma de la mano.