La nueva plataforma NVIDIA Vera Rubin se ha convertido en una de las grandes protagonistas del CES 2026, donde la compañía ha detallado cómo quiere marcar el ritmo de la próxima ola de centros de datos de inteligencia artificial. Se trata de un sistema de cómputo acelerado pensado como un único superordenador de IA, en el que hardware y software se han diseñado de forma conjunta para sostener modelos cada vez más grandes, razonadores y persistentes.

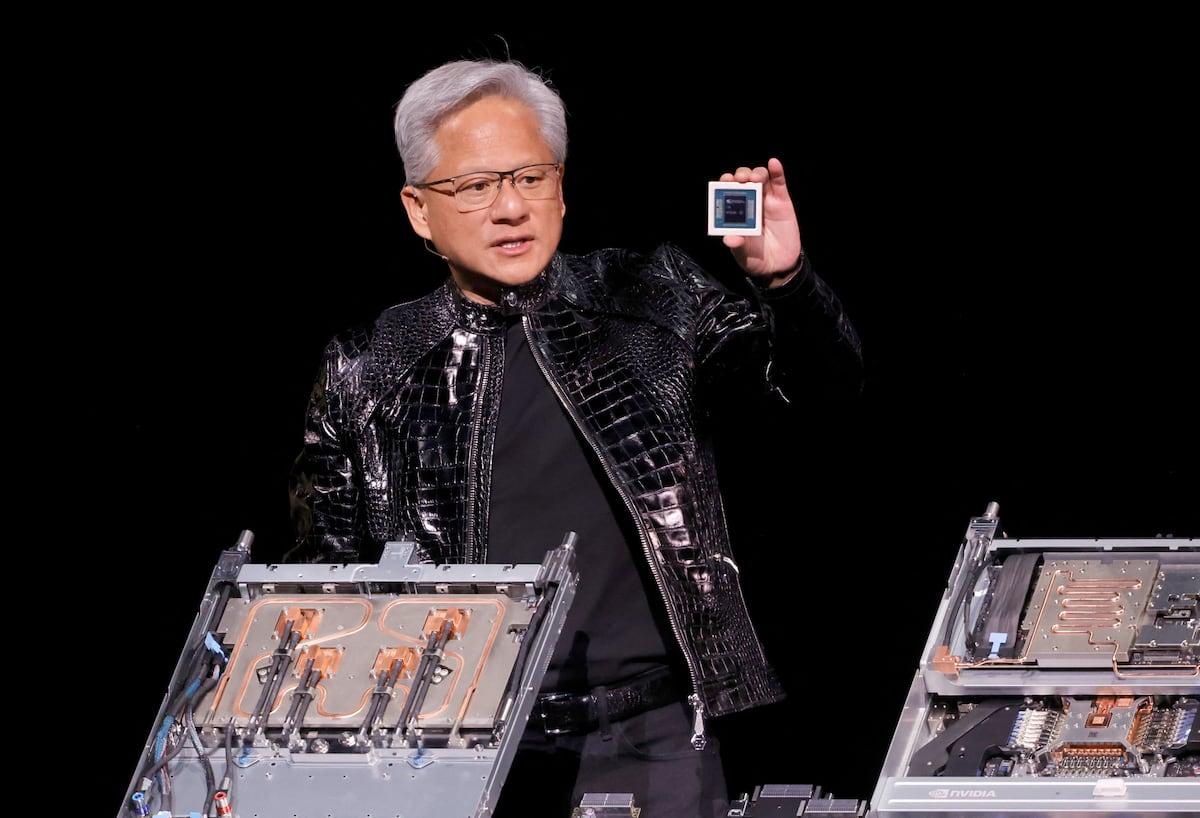

Según Jensen Huang, consejero delegado de NVIDIA, Vera Rubin ya está en plena producción y comenzará a llegar a clientes a lo largo de este año, con la vista puesta en despliegues masivos a partir de la segunda mitad de 2026. El objetivo es claro: ofrecer más rendimiento, reducir el consumo y bajar de forma notable el coste por token en entrenamiento e inferencia, especialmente en modelos de mezcla de expertos (MoE) y en IA agentica.

Qué es NVIDIA Vera Rubin y por qué es diferente

Vera Rubin no es solo una nueva GPU o una CPU más rápida: es una plataforma completa de seis chips que funcionan como un único sistema integrado. NVIDIA habla de “extreme codesign” para describir un enfoque en el que cada componente se ha concebido desde el principio para trabajar junto al resto, con especial atención al movimiento de datos, la eficiencia energética y la operación a gran escala.

En el corazón de la plataforma se encuentran la CPU NVIDIA Vera y la GPU NVIDIA Rubin, fabricadas con el proceso de 3 nanómetros de TSMC y conectadas mediante la última generación de interconexión NVLink. A su alrededor, otros cuatro chips completan el ecosistema: el switch NVIDIA NVLink 6, la SuperNIC NVIDIA ConnectX-9, la DPU NVIDIA BlueField-4 y el switch Ethernet NVIDIA Spectrum-6, todos ellos coordinados para que el sistema se comporte como un único superordenador de IA.

El resultado es la arquitectura a escala de rack NVIDIA Vera Rubin NVL72, tercera generación de este tipo de diseño en la compañía, que combina 72 GPUs Rubin y 36 CPUs Vera en un chasis modular, sin cableado interno visible y con refrigeración líquida integrada. A partir de estos racks, los grandes proveedores de nube y centros de datos en Europa pueden construir supercomputadores de IA del tipo DGX SuperPOD con decenas o cientos de miles de GPUs.

CPU NVIDIA Vera: 88 núcleos Olympus y memoria a gran escala

La CPU NVIDIA Vera representa la nueva apuesta de NVIDIA por el silicio ARM personalizado para centros de datos de IA. Esta CPU integra 88 núcleos Olympus con dos hilos por núcleo, lo que se traduce en 176 hilos gracias a la tecnología Spatial Multi-Threading, y es totalmente compatible con Armv9.2. Está pensada para orquestar flujos de datos masivos y coordinar agentes de IA complejos más que para tareas de computación generalista.

Uno de los puntos clave es el subsistema de memoria: Vera soporta hasta 1,5 TB de memoria LPDDR5X por CPU, triplicando la capacidad de la generación Grace, con un ancho de banda de 1,2 TB/s gracias al uso de módulos SOCAMM. Esta combinación permite manejar volúmenes de datos muy superiores a los habituales en servidores x86 tradicionales, algo fundamental para modelos de gran tamaño y cargas de trabajo de razonamiento continuo.

La interconexión con las GPUs se realiza mediante NVLink-C2C, que ofrece 1,8 TB/s de ancho de banda coherente entre CPU y GPU, el doble que en la generación anterior y hasta siete veces más rápido que PCIe Gen 6. Sobre el papel, esto se traduce en el doble de rendimiento en procesamiento de datos, compresión y flujos de compilación y despliegue (CI/CD) frente a Grace, reduciendo cuellos de botella en la fase previa al cómputo de IA puro.

GPU NVIDIA Rubin: potencia para inferencia y entrenamiento avanzados

La GPU NVIDIA Rubin es la pieza de cómputo específica para IA de la plataforma. Incluye un Transformer Engine de tercera generación con compresión adaptativa acelerada por hardware, capaz de ajustar dinámicamente la precisión en las distintas capas del modelo para exprimir rendimiento donde es posible sin comprometer la calidad de los resultados.

En términos de cifras, cada GPU Rubin alcanza 50 PFLOPS en inferencia NVFP4 y 35 PFLOPS en entrenamiento con el mismo formato, lo que supone hasta 5 veces más rendimiento en inferencia y unas 3,5 veces más en entrenamiento frente a las GPUs Blackwell. Para conseguirlo no solo se ha incrementado el número de transistores, sino que también se ha optimizado la estructura interna de los núcleos tensoriales y la gestión de precisión.

La memoria integrada también da un salto importante. Rubin es la primera GPU de la compañía en montar HBM4 con un ancho de banda de hasta 22 TB/s por chip, casi triplicando el ancho de banda efectivo respecto a lo que ofrecía Blackwell. Esta mejora es especialmente relevante para modelos de mezcla de expertos y sistemas multimodales de contexto largo, donde el acceso a la memoria se convierte en un factor limitante.

En el plano de la comunicación, cada GPU dispone de 3,6 TB/s de ancho de banda NVLink, el doble que en la generación anterior, lo que facilita el trabajo conjunto de grandes grupos de GPUs como si fueran una sola unidad lógica. En los sistemas Vera Rubin, cada módulo de cómputo integra dos GPUs Rubin junto a una CPU Vera, combinando así capacidad de cálculo y coordinación en un único superchip.

NVLink 6, ConnectX-9 y BlueField-4: la red como columna vertebral

Con modelos de IA cada vez más grandes, el reto ya no es solo calcular más rápido, sino mover datos con menos fricción. El switch NVIDIA NVLink 6 se encarga de interconectar las GPUs dentro del rack con hasta 3,6 TB/s por GPU y una capacidad total de 260 TB/s a escala de sistema, más del doble que la generación Blackwell Ultra. Este tejido de alta velocidad permite que cada GPU se comunique con todas las demás al mismo tiempo, algo crítico para arquitecturas MoE donde decenas o cientos de expertos deben intercambiar resultados de manera continua.

Además, NVLink 6 introduce cómputo integrado en la red, capaz de acelerar operaciones colectivas y reducir la congestión, lo que descarga parte del trabajo que de otro modo recaería en las propias GPUs. Todo el sistema está refrigerado por líquido, un requisito prácticamente indispensable en centros de datos de alta densidad que, en Europa, deben ajustarse a regulaciones cada vez más estrictas en materia de eficiencia energética.

Para la comunicación fuera del rack, la protagonista es la SuperNIC NVIDIA ConnectX-9, que ofrece hasta 1,6 TB/s de ancho de banda RDMA por GPU. Este adaptador de red se ha diseñado en conjunto con la CPU Vera e incorpora una ruta de datos acelerada y programable, de forma que los operadores de centros de datos puedan desplegar algoritmos de transferencia a medida para sus modelos de IA.

Completando el bloque de red, la DPU NVIDIA BlueField-4 asume tareas de red, almacenamiento y seguridad, liberando a las CPUs y GPUs para que se concentren en el cómputo de los modelos. Con 64 núcleos de CPU de nivel NVIDIA, el doble de ancho de banda de red (800 Gb/s) y seis veces más capacidad de cómputo que BlueField-3, esta DPU ofrece una base para construir una infraestructura nativa de IA capaz de escalar sin perder prestaciones.

Spectrum-6 y Spectrum-X: Ethernet pensada para fábricas de IA

Más allá del rack, la plataforma Vera Rubin se apoya en el switch Ethernet NVIDIA Spectrum-6 y en la familia Spectrum-X Ethernet Photonics para escalar supercomputadores de IA a la medida de los grandes proveedores de nube y centros de datos europeos. Basado en tecnología SerDes de 200G y óptica coempaquetada (CPO), este sistema de red ofrece hasta 102,4 Tb/s de capacidad de conmutación para tráfico este-oeste entre racks NVL72.

La integración de la óptica directamente sobre el silicio del switch, en lugar de recurrir a módulos conectables tradicionales, permite mejorar hasta 10 veces la fiabilidad, multiplicar por cinco el tiempo de actividad y lograr una eficiencia energética también cinco veces superior, según datos de la propia compañía. Para operadores que gestionan centros de datos distribuídos por Europa, esta reducción en fallos y consumo energético puede tener un impacto directo en costes operativos y cumplimiento normativo.

La plataforma Spectrum-X Ethernet está diseñada para mantener un 95 % de ancho de banda efectivo a escala, reduciendo las pérdidas típicas de otros diseños de red cuando se conectan cientos de racks. Además, la variante Spectrum-XGS permite que instalaciones separadas por cientos de kilómetros funcionen como un único entorno de IA, una opción interesante para grandes empresas europeas que deseen distribuir sus cargas de trabajo por motivos regulatorios, de resiliencia o de latencia.

Diseño de rack Vera Rubin NVL72: modular, sin cables y con mantenimiento simplificado

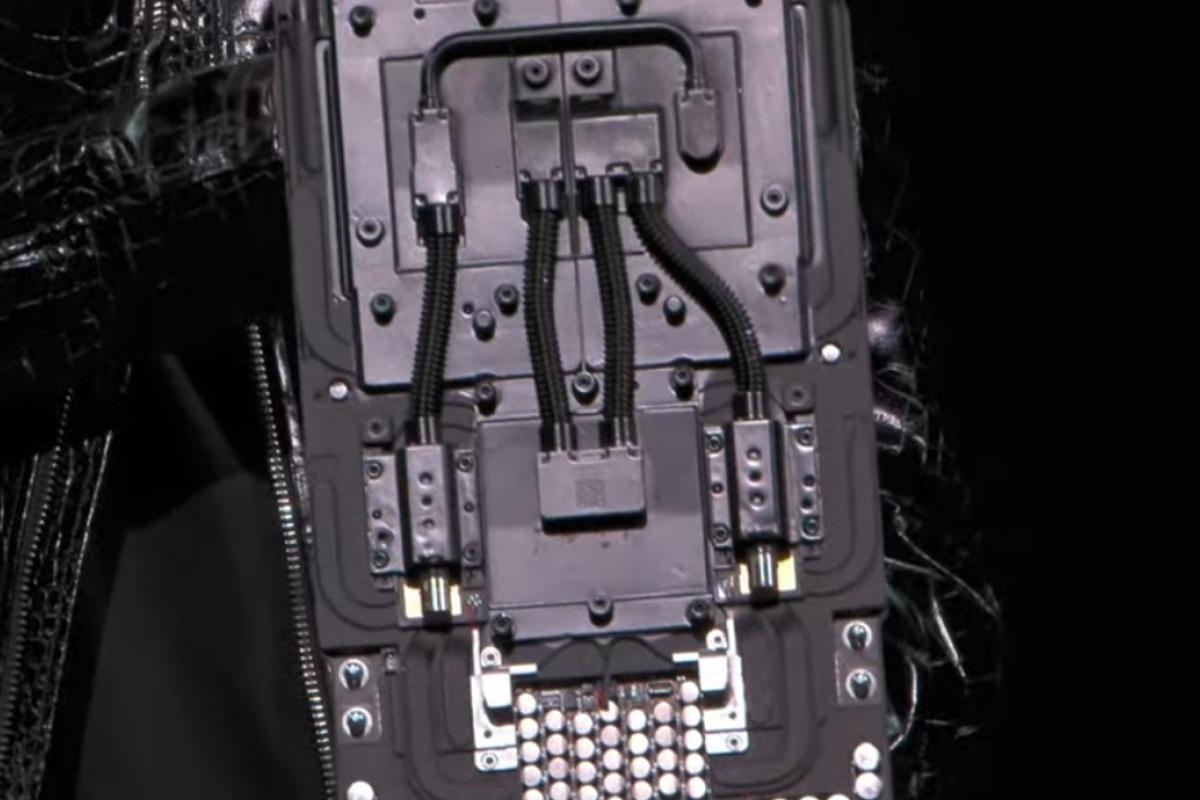

Uno de los elementos diferenciales de Vera Rubin es su diseño físico a escala de rack. El sistema NVIDIA Vera Rubin NVL72 utiliza un enfoque de bandejas modulares en el que las conexiones internas se realizan mediante PCB y conectores ciegos, sin cables, ventiladores ni mangueras en el interior del chasis de cómputo. Las únicas conexiones externas son las líneas de entrada y salida de refrigeración líquida hacia los bloques de intercambio térmico.

Este diseño reduce de forma drástica el tiempo de montaje y mantenimiento. Frente a generaciones anteriores, donde ensamblar una sola bandeja de cómputo podía requerir más de una hora y cada cable era un punto potencial de fallo, los racks Vera Rubin pueden desplegarse y repararse con una rapidez muy superior. NVIDIA habla de hasta 18 veces menos tiempo de montaje y de mejoras directas en el tiempo de actividad de clústeres con cientos de miles de GPUs.

El sistema también integra un motor RAS de segunda generación (Fiabilidad, Disponibilidad y Capacidad de servicio) que monitoriza en tiempo real el estado de GPUs, CPUs y enlaces NVLink. Las bandejas de conmutación NVLink admiten mantenimiento sin interrupción, lo que permite sustituir módulos o ampliar capacidad sin apagar el rack completo, una característica especialmente relevante para operadores de nubes públicas europeas que necesitan niveles de servicio muy altos.

Todo esto hace que la arquitectura esté preparada para configuraciones de mayor densidad y futuros diseños de rack, incluidos los que combinan GPUs Rubin con procesadores adicionales especializados en contexto, algo que NVIDIA ya ha empezado a esbozar en foros técnicos.

Inference Context Memory Storage: nueva capa de memoria para modelos gigantes

La otra gran pieza que NVIDIA ha destacado en Vera Rubin es la Inference Context Memory Storage Platform, una infraestructura de almacenamiento nativa de IA diseñada específicamente para la gestión de la caché clave-valor (KV cache) de los modelos Transformer. Esta capa se sitúa entre la memoria HBM de las GPUs y el almacenamiento tradicional, y se apoya en las DPUs BlueField-4 y en la red Spectrum-X.

El objetivo es abordar un cuello de botella que se ha vuelto crítico con los modelos de contexto largo: la caché KV crece de forma lineal con la longitud de la secuencia y el número de usuarios concurrentes, hasta el punto de saturar la HBM de las GPUs. Sin una capa intermedia optimizada, los operadores se ven obligados a reducir la ventana de contexto, los tamaños de lote o el número de peticiones simultáneas, o bien a adquirir más GPUs.

Con esta plataforma, NVIDIA promete hasta 5 veces más tokens por segundo que con almacenamiento de red tradicional, un rendimiento por dólar de coste total de propiedad (TCO) también hasta cinco veces superior y una mejora de unas 20 veces en el tiempo hasta el primer token. La clave está en la ubicación de caché KV acelerada por hardware en BlueField-4 y en el uso de RDMA sobre Ethernet optimizado para patrones de acceso aleatorio.

Desde el punto de vista del software, esta solución se integra con el proyecto de código abierto NVIDIA Dynamo y con bibliotecas como NIXL y DOCA, proporcionando un marco para desacoplar el almacenamiento de contexto del cómputo de GPU. De esta forma, las “fábricas de IA” pueden escalar la capacidad de contexto independientemente del número de GPUs, algo especialmente relevante para proveedores de servicios en la nube que operan en múltiples regiones europeas.

Seguridad y computación confidencial en todo el sistema

Vera Rubin NVL72 es la primera plataforma a escala de rack de NVIDIA con computación confidencial de tercera generación en todo el sistema. Esto significa que los datos permanecen protegidos no solo en reposo, sino también en tránsito y durante el procesamiento, abarcando CPU, GPU y todo el dominio NVLink, con cada bus cifrado.

Esta capa de seguridad está pensada para responder a una preocupación creciente entre empresas europeas y laboratorios de IA que operan en infraestructuras compartidas: cómo garantizar que modelos y datos propietarios se mantienen protegidos incluso cuando se ejecutan en centros de datos de terceros. En un contexto regulatorio cada vez más exigente en la UE, con normativas como el Reglamento de IA y el RGPD, este tipo de capacidades puede convertirse en un factor de decisión importante.

BlueField-4 añade además la arquitectura ASTRA (Advanced Secure Trusted Resource Architecture), que actúa como un punto de control único para aprovisionar, aislar y operar entornos de IA a gran escala. En la práctica, esto facilita la adopción de esquemas multi-tenant seguros, permitiendo que distintas organizaciones compartan una misma infraestructura física con garantías de segregación lógica y de rendimiento.

Rendimiento frente a Blackwell y mejoras en coste por token

Comparada con la anterior plataforma Grace Blackwell, NVIDIA asegura que Vera Rubin representa un salto generacional claro. A escala de rack, un Vera Rubin NVL72 ofrece unos 3,6 exaFLOPS en inferencia NVFP4 y alrededor de 2,5 exaFLOPS en entrenamiento, con mejoras adicionales en memoria y ancho de banda.

En términos de memoria, el sistema proporciona aproximadamente 2,5 veces más capacidad LPDDR5X (hasta 54 TB) y 1,5 veces más capacidad HBM4 (algo más de 20 TB), junto con un ancho de banda HBM4 2,8 veces superior (en el entorno de 1,6 PB/s a escala de rack) y un ancho de banda de escalado que se duplica hasta 260 TB/s. Estas cifras son relevantes para aplicaciones como modelos multimodales, sistemas de recomendación avanzados o grandes modelos de lenguaje con ventanas de contexto de millones de tokens.

La compañía sostiene, además, que Vera Rubin es capaz de entrenar modelos MoE con cuatro veces menos GPUs que Blackwell, manteniendo tiempos de entrenamiento equivalentes. En inferencia, se habla de una reducción de hasta 10 veces en el coste por token, lo que podría cambiar la economía de servicios de IA generativa de gran escala, incluidos los que se despliegan en nubes públicas europeas para sectores como banca, automóvil, administración pública o salud.

Para los grandes consumidores de cómputo de IA en Europa, estas mejoras en coste por token y eficiencia energética se traducen en menos presión sobre el consumo eléctrico de los centros de datos y en una mejor utilización del hardware ya instalado, algo cada vez más vigilado tanto por reguladores como por inversores.

Disponibilidad, socios y despliegues previstos en la nube

NVIDIA ha confirmado que Vera Rubin ya está en producción y que los primeros chips y sistemas llegarán a clientes este mismo año, aunque la disponibilidad generalizada a través de socios se espera para la segunda mitad de 2026. La plataforma se ofrecerá en dos formatos principales: el NVIDIA Vera Rubin NVL72, a escala de rack, y el NVIDIA HGX Rubin NVL8, una placa con ocho GPUs Rubin enlazadas por NVLink para integrarse en servidores basados en x86.

Entre los primeros proveedores de nube que desplegarán instancias basadas en Vera Rubin figuran AWS, Google Cloud, Microsoft y Oracle Cloud Infrastructure, además de socios de nube especializados como CoreWeave, Lambda, Nebius y Nscale. Microsoft, por ejemplo, tiene previsto instalar sistemas Vera Rubin NVL72 en sus nuevos centros de datos de IA, incluyendo proyectos de “superfábricas de IA” que se están desarrollando en distintas regiones.

En el ámbito europeo, actores como Google Cloud, AWS o Microsoft Azure gestionan regiones de nube en países como España, Alemania, Francia, Italia, Países Bajos o Irlanda, lo que abre la puerta a que empresas y administraciones públicas de la UE puedan acceder a instancias basadas en Vera Rubin sin necesidad de desplegar hardware propio. La compatibilidad con tecnologías de computación confidencial y las capacidades de particionado seguro son factores que encajan con las exigencias normativas europeas en materia de protección de datos.

Fabricantes de servidores como Cisco, Dell Technologies, HPE, Lenovo y Supermicro también planean ofrecer sistemas basados en Rubin, mientras que una larga lista de laboratorios de IA y startups —entre ellos Anthropic, Black Forest Labs, Cohere, Harvey, Meta, Mistral AI, OpenAI, Perplexity, Runway, Thinking Machines Lab y xAI— ya han anunciado su intención de entrenar modelos más grandes sobre esta plataforma.

Ecosistema de software y colaboración con Red Hat y otros socios

Más allá del hardware, NVIDIA insiste en que la plataforma Vera Rubin se apoya en un ecosistema de software y herramientas que abarca desde el sistema operativo hasta las bibliotecas de desarrollo y la gestión del ciclo de vida de los modelos. Red Hat ha anunciado una colaboración ampliada para optimizar su pila de nube híbrida —incluyendo Red Hat Enterprise Linux, OpenShift y Red Hat AI— específicamente para la plataforma Rubin.

Esta integración está orientada a facilitar el despliegue de “fábricas de IA” sobre infraestructuras mixtas, combinando recursos on-premises y nube pública. En Europa, donde muchas organizaciones optan por modelos híbridos para equilibrar control de datos y flexibilidad, esta aproximación puede resultar especialmente relevante.

En paralelo, empresas de almacenamiento e infraestructura como VAST Data, NetApp, DDN, Dell, HPE, Hitachi Vantara, IBM, Nutanix, Pure Storage, SUSE, WEKA y otros socios trabajan en plataformas compatibles con BlueField-4 y Spectrum-X para ofrecer soluciones de datos optimizadas para cargas de trabajo de IA. Estas alianzas buscan que la adopción de Vera Rubin no se limite a un conjunto cerrado de productos, sino que se integre en arquitecturas de centro de datos ya existentes.

Sobre esta base se apoyan también los DGX SuperPOD, que actúan como referencia de NVIDIA para despliegues a gran escala. Estos sistemas integran racks Vera Rubin NVL72 o placas HGX Rubin NVL8 con DPUs BlueField-4, SuperNICs ConnectX-9, redes InfiniBand y el software de gestión NVIDIA Mission Control, que ayuda a monitorizar y optimizar el uso de los recursos en tiempo real.

NVIDIA Vera Rubin se presenta como una plataforma pensada para sostener la siguiente etapa de la inteligencia artificial, en la que los modelos dejan de ser meras herramientas de respuesta puntual para convertirse en sistemas de razonamiento continuo y agentes capaces de operar sobre grandes volúmenes de datos. Con mejoras notables en rendimiento, memoria, red, seguridad y eficiencia, y con un ecosistema de socios que incluye a los principales proveedores de nube y fabricantes de servidores, la propuesta apunta directamente a quienes necesitan escalar centros de datos de IA en Europa y otras regiones sin disparar costes ni complejidad operativa.