La demanda de cómputo para inteligencia artificial está elevando la temperatura de los centros de datos hasta niveles delicados, con GPUs cada vez más cerca de su límite térmico y eléctrico. Operadores de hiperescala y colocation encaran un reto mayúsculo: mantener el rendimiento sin disparar el consumo energético.

En este contexto, Microsoft ha validado en laboratorio una refrigeración líquida por microfluidos integrada en el propio chip, que lleva el refrigerante justo donde se genera el calor. La propuesta busca aliviar el cuello de botella térmico de la IA con una solución más eficiente que la refrigeración convencional por placas.

Qué ha anunciado Microsoft y por qué es relevante

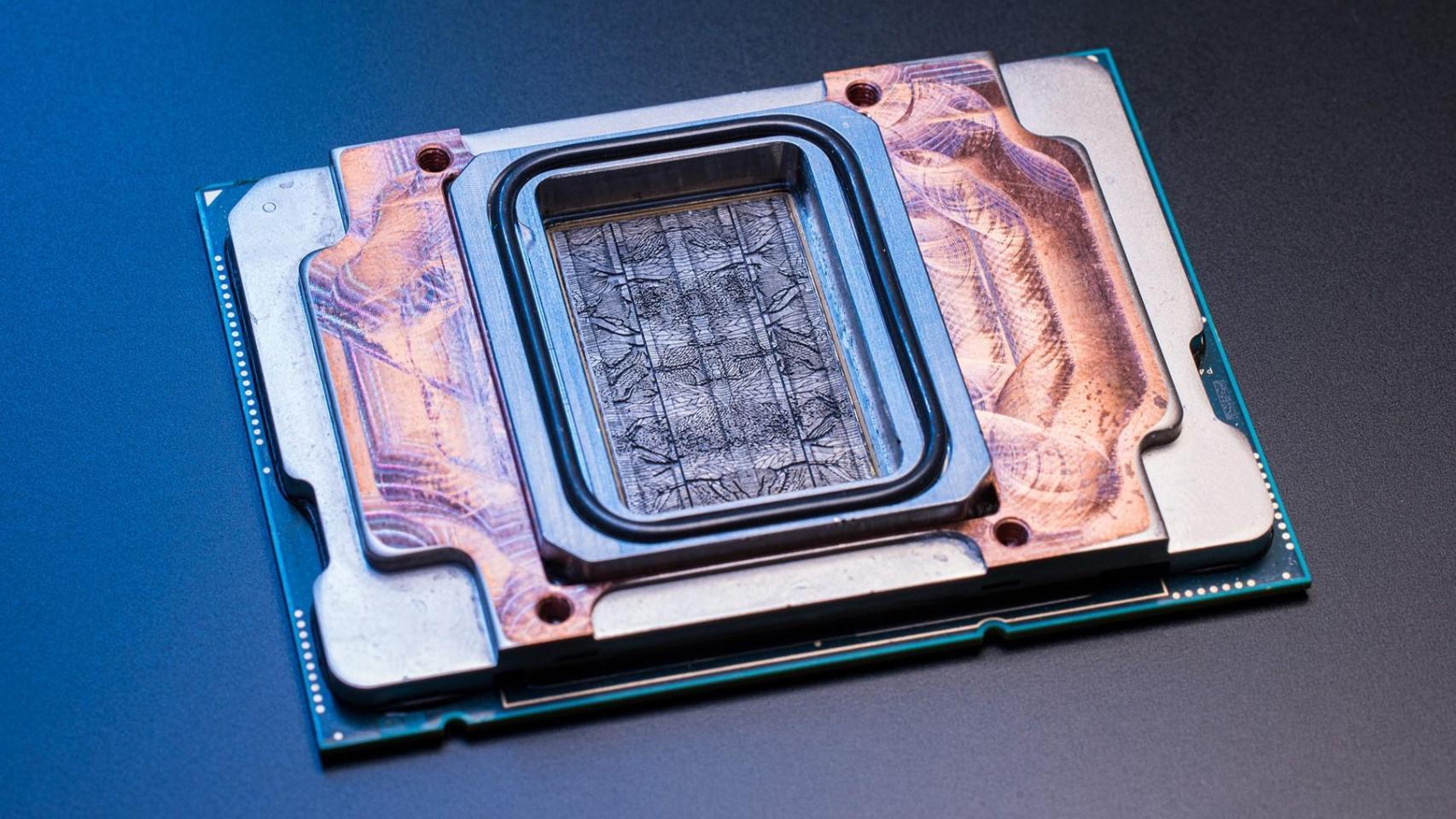

La compañía ha mostrado un sistema que graba parte posterior del silicio, de un grosor comparable al de un cabello, por los que circula un líquido refrigerante de manera dirigida. Al acercar el fluido a la fuente de calor, se reduce la resistencia térmica y se mejora notablemente la disipación frente a las placas frías tradicionales.

Según las pruebas compartidas, la solución puede ser hasta tres veces más eficaz que los métodos habituales en centros de datos. Este rendimiento térmico superior permitiría operar chips a mayores cargas sin penalizaciones por throttling y con un margen adicional para gestionar picos de trabajo.

El diseño se ha desarrollado junto a la startup suiza Corintis y emplea una malla de canales inspirada en la naturaleza, similar a las venas de una hoja, para distribuir el caudal con uniformidad. Microsoft indica que ha realizado cuatro iteraciones en un año hasta dar con la arquitectura óptima.

Cómo funciona la refrigeración por microfluidos

La clave es conducir el refrigerante a través de microcanales capilares grabados en el propio chip, justo detrás de las zonas de mayor flujo térmico. Así, el calor se extrae en origen y no a través de capas intermedias de materiales, como ocurre con las placas frías, que añaden interfaces y pérdidas.

Además, Microsoft emplea modelos de IA para detectar hotspots en tiempo real y gestionar el caudal con precisión milimétrica. Esta orquestación dinámica dirige más fluido a las áreas críticas, optimizando la transferencia de calor en función de la carga.

El enfoque exige ingeniería fina: los canales han de ser lo bastante profundos para sostener el flujo, pero sin comprometer la integridad del chip ni provocar fugas. Durante el desarrollo se evaluaron diversos refrigerantes hasta encontrar la formulación que equilibrase rendimiento, fiabilidad y compatibilidad con el sistema.

Desde el equipo de Innovación y Operaciones Cloud subrayan la necesidad de una visión de conjunto: comprender la interacción entre silicio, refrigerante, servidor y centro de datos es esencial para capturar todo el beneficio del sistema y evitar cuellos de botella desplazados.

Resultados y efectos en los centros de datos

En condiciones de laboratorio, Microsoft reporta una reducción de hasta el 65% del pico térmico en GPU, dependiendo del chip y la carga. Con menos calor acumulado, es posible sostener frecuencias más altas con seguridad, elevar la densidad por rack y posponer la construcción de nuevos edificios.

La mayor eficacia térmica también repercute en la eficiencia energética del sitio: disminuye la energía requerida para enfriar el líquido, mejora el PUE (Power Usage Effectiveness) y genera un calor residual de mayor calidad, más apto para su recuperación.

A nivel de sala, una disipación más efectiva permite bastidores más cercanos y menos restricciones de separación, lo que puede reducir latencias internas y simplificar la operación. Para los operadores, el ahorro potencial se extiende a energía, espacio y mantenimiento.

En el plano estratégico, la compañía prevé integrar esta tecnología en sus chips Cobalt y Maia en futuras generaciones, en colaboración con fabricantes de silicio. Microsoft vincula este avance a un plan de inversión de 30.000 millones de dólares (cerca de 24.500 millones de euros) en infraestructura de IA, si bien no ha comunicado un calendario de despliegue masivo.

Más allá del corto plazo, acercar la refrigeración al silicio abre la puerta a arquitecturas 3D, tradicionalmente limitadas por el calor. Si se controla la temperatura entre capas apiladas, el salto a diseños más compactos y potentes se vuelve más factible sin pagar un peaje energético desproporcionado.

Con el auge de la IA elevando el listón térmico, canalizar el refrigerante dentro del chip se perfila como un cambio de enfoque: una forma de contener el calor en la fuente, ganar margen operativo y recortar consumos donde más duele, sin florituras ni fuegos artificiales, pero con impacto claro en rendimiento y sostenibilidad.